Por Brian Fonseca, Director del Jack D. Gordon Institute for Public Policy en Florida International University, y Nicole Writt, Coordinadora de Investigación del Jack D. Gordon Institute, FIU.

La inteligencia artificial es la nueva frontera de la guerra. Máquinas que piensan, deciden y actúan a velocidades inimaginables están cambiando de manera fundamental la forma en que se conciben y se libran los conflictos internacionales. ¿Cómo, y con qué riesgos, transformará la IA el campo de la defensa?

La inteligencia artificial es la nueva frontera de la guerra. Máquinas que piensan, deciden y actúan a velocidades inimaginables están cambiando de manera fundamental la forma en que se conciben y se libran los conflictos internacionales. ¿Cómo, y con qué riesgos, transformará la IA el campo de la defensa?

La inteligencia artificial (IA) tiene sus orígenes en investigaciones de mediados del siglo XX, pero fue en las últimas décadas cuando su desarrollo y aplicación cobraron un ritmo acelerado. Lo que comenzó como una disciplina experimental se ha convertido en una infraestructura transversal que impacta todos los sectores de la vida social, incluyendo, por supuesto, la seguridad y la defensa. En este nuevo escenario, toda organización debe pensarse como una organización tecnológica. El Ejército, la Armada y la Fuerza Aérea no operan al margen de la transformación digital: son y serán organizaciones estructuralmente atravesadas por la rápida evolución tecnológica, especialmente la inteligencia artificial. Esto plantea un desafío profundo, no solo técnico, sino también institucional, estratégico y cultural.

La IA no será un simple complemento: será un factor disruptivo que alterará las formas tradicionales de planificar, operar y tomar decisiones. El ritmo de evolución de la inteligencia artificial supera con creces la capacidad de los marcos institucionales y regulatorios para seguir su transformación. La brecha entre el estado del arte en la investigación científica y las aplicaciones disponibles en el dominio público no deja de ampliarse. Tecnologías como los modelos de lenguaje generativo, que ganaron visibilidad global con la aparición de sistemas como ChatGPT, representan apenas una fracción de lo que se está desarrollando en laboratorios de vanguardia. Desde el punto de vista técnico, se estima que la ciencia vinculada a la IA ha avanzado al menos dos o tres generaciones más allá de lo que actualmente está disponible de manera comercial o pública.

Esta brecha es relevante por varias razones. En primer lugar, porque limita la capacidad de los gobiernos y las sociedades para anticipar el impacto de tecnologías que aún no han llegado al mercado pero cuya implementación podría ser inminente. En segundo lugar, porque consolida una asimetría de información y poder en favor de quienes tienen acceso a los desarrollos más avanzados —generalmente grandes corporaciones y actores estatales con importantes recursos— en detrimento del resto de la comunidad internacional. Esta dinámica robustece un modelo de innovación cerrado, opaco y difícil de gobernar.

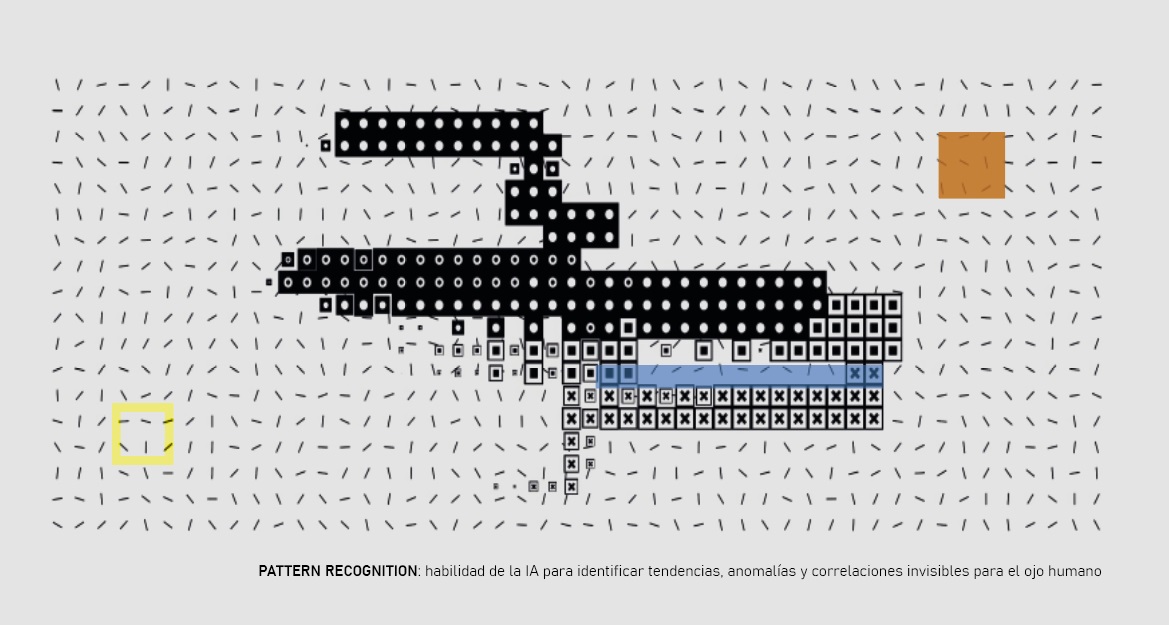

Las múltiples clasificaciones que organizan el campo de la inteligencia artificial —inteligencia estrecha, general o superinteligencia; máquinas reactivas, de memoria limitada o autoconscientes— son útiles en entornos técnicos o académicos, pero explican poco sobre cómo estas tecnologías están reconfigurando el equilibrio global de poder y la toma de decisiones. El debate no debería centrarse tanto en qué tipo de IA podría desarrollarse en el futuro, sino en cómo se está utilizando hoy: con qué capacidades, en manos de quién y bajo qué niveles de supervisión política y social. En el ámbito de la defensa, lo que está en juego no es una definición teórica, sino la emergencia de sistemas capaces de procesar datos en tiempo real, anticipar escenarios y proponer cursos de acción, muchas veces sin intervención humana directa. En ese desplazamiento silencioso —del asesoramiento al reemplazo— se concentra uno de los dilemas más urgentes de nuestra época.

Existe un debate global en torno a la inteligencia artificial y la interacción humano-máquina. Este es un eje crítico para pensar el diseño de doctrinas, protocolos de uso y límites éticos en contextos de seguridad. Un enfoque posible identifica cuatro formas principales de interacción, que estructuran el modo en que se conciben y aplican estos sistemas.

La primera modalidad concibe a la máquina como asesora: en este rol, los sistemas de IA proveen análisis, recomendaciones y perspectivas que apoyan la toma de decisiones humanas. Por ejemplo, en entornos académicos y militares se desarrollan tableros de control (dashboards) que procesan grandes volúmenes de datos para facilitar la inteligencia y orientar decisiones estratégicas. La máquina actúa como un complemento que ayuda a filtrar y organizar la información, permitiendo a los decisores enfocarse en las opciones más relevantes. En esta relación, el humano conserva el control final y puede decidir cuándo y cómo interactuar con la máquina.

La segunda modalidad refiere a la máquina como extensión del ser humano. En este caso, la IA automatiza tareas repetitivas o complejas que amplifican la capacidad operativa del agente humano. Esto permite mejorar la eficiencia y liberar recursos cognitivos para actividades de mayor valor estratégico. Por ejemplo, la automatización de procesos logísticos o el apoyo en el análisis de inteligencia se inscriben en esta categoría.

El tercer modelo implica que las máquinas actúen como colaboradoras. Aquí, la interacción es más integrada y cooperativa, con máquinas que trabajan directamente junto a humanos en la ejecución de tareas. Un ejemplo típico es el uso de drones operados en conjunto con personal de seguridad para detectar artefactos explosivos improvisados. Estas máquinas no solo extienden la capacidad humana, sino que participan activamente en el proceso operativo, funcionando como compañeras en el terreno.

Finalmente, la cuarta modalidad posiciona a las máquinas como agentes autónomos, capaces de actuar en nombre del humano a gran escala y sin intervención directa en cada acción. Este es el nivel más avanzado y controvertido, ya que implica delegar decisiones y operaciones críticas a sistemas automatizados. En contextos de seguridad y defensa, esta modalidad puede ofrecer ventajas competitivas significativas, pero plantea importantes interrogantes sobre responsabilidad, control y ética.

Estas cuatro formas de interacción resumen cómo la IA se está integrando progresivamente en las fuerzas armadas y en las organizaciones de seguridad, transformando sus estructuras y modos de operación. Al mismo tiempo, el debate sobre la convergencia entre inteligencia artificial y ciberseguridad cobra una centralidad creciente, dado que la expansión de los sistemas digitales abre nuevas vulnerabilidades y vectores de ataque. En Estados Unidos, por ejemplo, se han desarrollado amplias estrategias destinadas a fortalecer la capacidad humana para enfrentar amenazas cibernéticas emergentes, al tiempo que se reconoce el papel creciente de la IA en este terreno.

La convergencia entre IA y ciberseguridad

La rápida proliferación de dispositivos conectados a redes globales —con un nuevo equipo incorporado aproximadamente cada 1,6 segundos— expande de forma exponencial la superficie de ataque digital y complejiza el panorama de amenazas. Esta expansión no solo afecta a infraestructuras civiles o económicas, sino que impacta directamente a las instituciones militares, que deben afrontar un escenario de creciente sofisticación y escala en los ciberataques. América Latina, y en particular sus fuerzas armadas, ya han sido blanco de ofensivas cibernéticas por parte de organizaciones criminales, con objetivos que van desde la obtención de inteligencia hasta el sabotaje y la guerra informacional.

Este fenómeno de fusión entre inteligencia artificial y ciberseguridad se manifiesta con gran intensidad y rapidez, lo que obliga a repensar la estrategia y las capacidades defensivas. En el análisis de este vínculo, es posible distinguir dos grandes categorías operativas: ofensiva y defensiva, o, dicho de otro modo, estar en el campo de batalla o en el banco técnico, supervisando y analizando.

En términos generales, las organizaciones militares desempeñan un rol mayoritariamente defensivo, si bien existen capacidades limitadas y reguladas para la acción ofensiva. La mayoría de los esfuerzos se concentra en proteger sistemas, detectar anomalías, predecir amenazas y desarrollar mecanismos automáticos para identificar y neutralizar ataques en tiempo real. Esta función es crítica no solo para instituciones estatales, sino también para individuos y empresas, que recurren a servicios avanzados para monitorear constantemente los riesgos digitales.

Una de las innovaciones más relevantes en el campo defensivo es la incorporación de sistemas automatizados de prueba de penetración. Tradicionalmente, esta tarea requería especialistas humanos que simulaban ataques para identificar vulnerabilidades. Hoy, máquinas dotadas de inteligencia artificial comienzan a desempeñar ese papel, aumentando la capacidad de detección de brechas y mitigación de riesgos. Si bien sigue siendo necesaria la formación de profesionales calificados, la complementariedad con tecnologías avanzadas es esencial para cerrar la brecha entre la demanda y la oferta de recursos humanos en ciberseguridad.

En el plano ofensivo, actores criminales y adversarios explotan la inteligencia artificial para potenciar sus métodos de ataque. Emplean malware con capacidad de autoaprendizaje, amplifican el alcance de ataques de ransomware y llevan a cabo sofisticadas operaciones de ingeniería social. Estas herramientas se dirigen no solo contra objetivos militares directos, sino también contra proveedores y empresas que forman parte de las cadenas de suministro vinculadas a la defensa, incrementando así la vulnerabilidad sistémica.

Además, la IA contribuye a la expansión de campañas masivas de desinformación mediante el uso de bots capaces de generar narrativas falsas en redes sociales a una escala y velocidad imposibles de replicar por operadores humanos. Este fenómeno afecta la percepción pública y la cohesión social, elementos esenciales para la estabilidad de los Estados en contextos de conflicto.

Ética y letalidad autónoma

El debate sobre el uso letal de la inteligencia artificial ha cobrado creciente relevancia, especialmente en Estados Unidos, pero también a nivel global. La pregunta central es si resulta admisible que las máquinas puedan tomar decisiones autónomas sobre el uso de la fuerza letal, desplazando la intervención humana directa. Aunque la doctrina actual evita delegar completamente estas decisiones, ya existen sistemas automatizados en funciones críticas como la defensa activa, donde el margen de tiempo para reaccionar es mínimo. Estos casos evidencian la tensión entre la necesidad de velocidad y precisión operativa y los imperativos éticos de control y responsabilidad.

Un ejemplo es el sistema de misiles superficie-aire, que debe responder a amenazas en cuestión de segundos. Si bien una decisión rápida puede salvar vidas, también conlleva el riesgo de errores catastróficos, como el derribo accidental de una aeronave civil. En 1988, por ejemplo, la Armada de Estados Unidos derribó por error un avión comercial iraní, provocando la muerte de las 290 personas a bordo: una trágica consecuencia del error humano.

Frente a estos dilemas, se han desarrollado marcos éticos para guiar el uso responsable de la IA en el ámbito de la defensa. El Departamento de Defensa de EE.UU. adoptó cinco principios fundamentales para el desarrollo y uso de IA con fines militares: responsabilidad (asegurar la supervisión humana en las decisiones), equidad (evitar sesgos no deseados), trazabilidad (garantizar la transparencia de los métodos), confiabilidad (exigir desempeño constante y predecible) y gobernabilidad (garantizar la posibilidad de desconectar o desactivar los sistemas si actúan de forma inesperada).

Estos principios buscan equilibrar el avance tecnológico con la preservación de valores fundamentales, recordándonos que, más allá de las máquinas, la dimensión humana debe seguir ocupando el centro de las decisiones que pueden afectar la vida o la muerte.

A medida que se otorga mayor autonomía a los sistemas, resulta imprescindible contar con mecanismos eficaces para desactivarlos con rapidez en caso de un comportamiento indeseado. El diseño de estos sistemas debe contemplar un “botón de apagado” confiable, junto con monitoreo humano constante, transparencia y trazabilidad en las decisiones.

En América Latina, donde la regulación sobre IA se encuentra aún fragmentada y en etapas dispares, es necesario encontrar un equilibrio entre fomentar la innovación y establecer resguardos efectivos. Una vía posible son los marcos regulatorios que promueven los llamados regulatory sandboxes o entornos de prueba controlados, donde las nuevas tecnologías puedan ser evaluadas en condiciones seguras, con la supervisión adecuada. Sin embargo, esta es apenas una medida inicial: la cooperación regional será esencial para desarrollar marcos similares que garanticen continuidad y coherencia en la región.

La inteligencia artificial está transformando el ámbito de la defensa y la seguridad, planteando desafíos tecnológicos, estratégicos y éticos sin precedentes. Frente a estas transformaciones, resulta esencial fortalecer la cooperación regional, promover un diálogo inclusivo entre actores gubernamentales, académicos y del sector privado, y construir marcos éticos compartidos que regulen el despliegue de estas tecnologías. La formación continua y los ejercicios conjuntos serán fundamentales para integrar la IA y la ciberseguridad en las instituciones militares de forma eficaz y alineada con los valores democráticos.